Ich schreibe meistens über Dinge, die mich begeistern oder eben nicht. Mehr zu uns findest du auf der Agentur-Seite.

SEO Trends 2022

Optimiere nicht an deinen Usern vorbei, indem du SEO Tipp X befolgst. Hier erfährst du stattdessen, warum es sich für alle Beteiligten lohnt, wenn deine Inhalte originell und strukturiert sind und warum du auf die Suchabsicht und Keywords deiner Zielgruppe setzen solltest.

Aktualisiert am 10.02.2022

Es ist nicht alles Gold, was glänzt

Liest man SEO Blogs, fällt einem auf, wie widersprüchlich die im Netz verstreuten SEO Tipps eigentlich sind. Wir zeigen dir hier deswegen einige SEO Trends für 2022, die wir direkt mit Quellen von Google oder mit statistischen Methoden begründen.

Zudem erklären wir, warum viele SEO Tipps und Tricks schlicht nur heisse Luft sind. Dafür müssen wir aber erst einmal klären, woran Google, Unternehmen und die Nutzerinnen der Google Suche interessiert sind.

Es steckt zwar auch viel komplexe Technik dahinter, aber die wichtigsten Google Ranking Faktoren sind einfach zu verstehen und können dir ohne grossen Aufwand zu besseren Rankings verhelfen.

Konkret wird es um nachfolgende Themen gehen. Falls du nur an einem bestimmten Thema interessiert bist, kannst du mit diesen Links gleich dahin springen. Der Artikel verweist hier und da auf bereits Gesagtes, die einzelnen Abschnitte sollten aber auch so verständlich sein.

SEO Fakten/Trends

- Structured Data

- Content ist immer noch King

- IndexNow

- EAT Faktoren

- User Intent

- Customer Journeys

- Barrierefreiheit

Irreführende SEO Tipps widerlegt

- Mindestens 1000 Wörter um zu ranken

- Google bewertet einzelne Webseiten, nicht ganze Domains

- Barrierefreiheit als Rankingfaktor

- Machine Learning automatisiert SEO

Analysen und Erklärungen

- Die wirtschaftlichen Interessen von Google

- Alle profitieren dank SEO

- Search Console

- Crawlbudget beim Indexieren beachten

- 13 Design Trends für behindertengerechtes Webdesign

- Continuous Scroll kommt für Mobilgeräte

- Fazit

Zwei Business Cases als Grundlage

Obwohl die Google Suche kostenlos ist, steht dahinter immer noch ein Multimilliarden-Dollar-Unternehmen, welches auf Rendite bedacht ist. Das Ziel von Google müsste es demnach sein, möglichst viele Werbeanzeigen ausspielen zu können, weil Google mit jedem Anzeigenklick Geld verdient.

Das geschieht allerdings nur, wenn die Anzeigen relevant für die Suchanfragen sind. Und die Menschen benutzen Google wiederum nur, weil die Suchresultate zufriedenstellend für ihre Suche sind. Dementsprechend ist dem Suchgigant daran gelegen, die besten Suchresultate auszuspielen, damit möglichst viele Leute die Suchmaschine benutzen.

Andere Unternehmen möchten indes potenzielle Kundinnen erreichen und zu einer Conversion bewegen (z.B. zu einem Produktkauf oder zu einer Kontaktanfrage). Werden diese beiden Geschäftsinteressen zusammengeführt, ergibt das ein erstaunlich starkes Argument für technisch und inhaltlich hochstehende Webseiten, weil die Nutzerinnen, die Unternehmen und nicht zuletzt Google selbst davon profitieren.

Das ist ein solides gedankliches Grundgerüst, welches man sich immer im Hinterkopf behalten sollte, weil SEO, SEA und SEM darauf aufbauen.

Das grosse Missverständnis

Die SEO Guru Formel lautet dann meistens «Setze jetzt SEO Massnahme X für Suchmaschinenerfolg um!». Die oben genannten wirtschaftlichen Interessen werden dabei meistens vergessen. Deswegen ist auch hier die Ansicht, dass es sich bei diesen Massnahmen um einzelne SEO Faktoren handelt, welche zufälligerweise für alle Parteien profitabel sind. Google schreibt nämlich nicht vor, wie das Internet funktioniert, obwohl der Suchgigant natürlich auch seine Spuren hinterlässt.

Allerdings muss Google dem Geschäftsinteresse folgend Wert darauf legen, welche dieser technischen und inhaltlichen Anpassungen die Nutzerinnen dazu bewegen, die Google Produkte häufiger zu benutzen. Der ständigen Weiter- und Neuentwicklung von Webtechnologien geschuldet werden diese Empfehlungen auch laufend geprüft, angepasst und in der Search Central Dokumentation gesammelt.

Ein praktisches Beispiel

Sollte sich herausstellen, dass mal mehr oder mal weniger Inhalte gut ranken, werden die Tipps der SEO Experten entsprechend angepasst. Hiess es früher noch, dass eine Webseite mindestens 600 Wörter oder mehr beinhalten muss, räumen heute teilweise Webseiten mit minimalem Content Platz 1 in den Suchresultaten ab.

Wieso? Weil die Länge des Inhalts wie auch alle anderen Faktoren wieder in dieses gedankliche Grundgerüst von oben eingebettet werden muss. Bei beliebten Webseiten mit wenig Inhalt (z.B. Spotify) muss es Google trotzdem möglich sein, diese Seiten weit oben in den Suchresultaten auszuliefern. Könnte Google Spotify Interessenten nicht mit der Google Suche zufriedenstellen, würden sie sich anderen Suchmaschinen zuwenden.

Korrelation ≠ Kausalität

Liest man Passagen wie die nachfolgend zitierte, kommt man deswegen nicht ins Grübeln, sondern ins Kopfschütteln:

«A recent study by Moz and Buzz Sumo analysed 1 million websites in their search for the optimal content length for SEO. They concluded that 85% of online content was below the 1,000-word count. Therefore, if you want your blogging content to go viral, you should be aiming for longer posts of at least 2,000 words.»

Quelle: greatcontent.com/seo-content-length-does-size-matter/

Den Backlink schenke ich ihnen nicht, weil mir der Content nicht gefällt. Deswegen bitte eben selbst die URL kopieren, falls Interesse besteht.

Im zitierten Absatz wird behauptet, dass 85% der Inhalte im Web weniger als 1000 Wörter lang sind und dass deswegen, falls man viral gehen möchte, die eigenen Inhalte mindestens 2000 Wörter umfassen sollen. Die implizierte Logik ist wohl, dass man sich damit von der Mehrheit abhebt und deswegen an Popularität gewinnt.

Warum aber die Anzahl der Wörter einen positiven Einfluss auf die Popularität haben soll, wird nicht erklärt. Etwas weiter oben wird eine andere Studie herangezogen und gesagt, dass längere Artikel häufiger geteilt und rückverlinkt werden als kürzere Artikel, aber wieder nicht, warum das der Fall sein soll.

Auch kein Ergebnis ist ein Ergebnis

«We have not undertaken any detailed linear regression modelling or built any predictive models but it does appear that a combination of factors can increase shares, links and the correlation.»

Quelle: Der moz.com Blog

Hier verlinke ich gerne auf die Quelle, weil sie logisch nachvollziehbar ist und mehrheitlich wissenschaftlich vorgeht. (Nur mehrheitlich, weil zum Beispiel die Indikatoren für die Faktorenanalyse nicht erläutert werden.)

Für alle, die aufgrund solcher Aussagen SEO Massnahmen mit möglicherweise weitreichenden Konsequenzen für ihr Unternehmen umsetzen, wäre deswegen eine simple Aussage ohne Handlungsaufforderung verständlicher gewesen: 85% von allen Online-Inhalten umfassen weniger als 1000 Wörter.

Dann hätte man noch ergänzen können, dass die Kombination aus mehreren Faktoren insgesamt zu einer grösseren Zahl an Backlink Domains geführt haben. Zu guter Letzt hätte man dann noch verdeutlichen können, dass man zwar keine datenbasierte Erklärung für diese Beobachtung hat, aber trotzdem aufgrund der Datenlage eine oder zwei Vermutungen bezüglich der Variable mit dem grössten Einfluss aufstellen kann.

Stattdessen beruft sich der Blog auf eine andere Studie von OkDork, welche unter anderem das hier schreibt:

Structured Data schafft Abhilfe bei Wortschwall

«There was 16 times more content with less than 1,000 words than there was content with 2,000+ words. This tells us that most people just aren’t willing to create in-depth, well-researched articles packed with insights.»

Quelle: okdork.com/why-content-goes-viral-what-analyzing-100-millions-articles-taught-us/

Und bewusst wieder keine Verlinkung, weil es sich bei dieser Aussage um reine Mutmassung handelt. Die Argumentation klingt zwar plausibel, aber die Begründung dafür ist an den Haaren herbeigezogen, weil weder die Qualität der erwähnten Artikel, noch die Meinung der Leute, die ihnen hier so frech unterstellt wird, messbar gemacht und dokumentiert wurde.

Diesen zwar leicht verständlichen, aber schlichtweg erfundenen “Fakten” verdanken wir unter anderem Rezeptseiten, welche erst einmal eine halbe Lebensgeschichte erzählen, bevor sie zu dem kommen, was eigentlich relevant ist: dem Rezept. Glücklicherweise gibt es dafür mittlerweile ein Gegenmittel in Form von Structured Data, was wir verständlich in unserem Blogpost dazu erklären.

Sind die Ergebnisse nicht aussagekräftig genug, um klare SEO Massnahmen an Kundinnen auszusprechen, ist auch das ein valides Ergebnis. Für Blogs, die mit Effekthascherei Views und Shares generieren, mag das nicht weiter wichtig sein. Uns als Schweizer SEO-Agentur hingegen liegt die Datenqualität am Herzen. Setzen wir SEO Empfehlungen im Namen unserer Kundinnen um, gibt es keinen Platz für Mutmassungen.

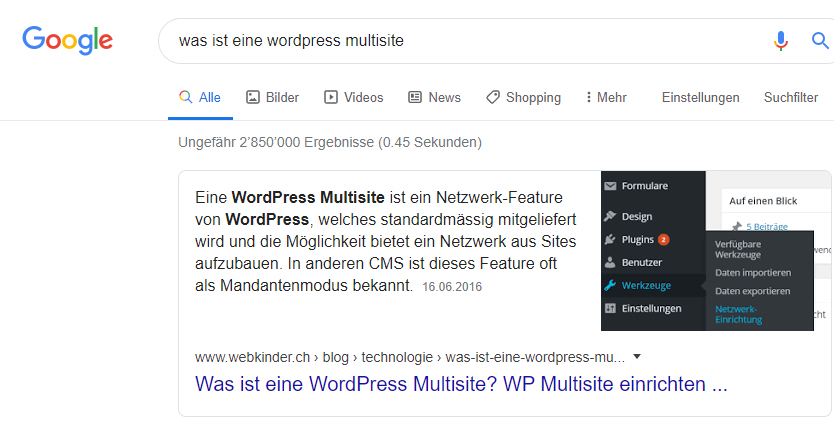

Wie löst Google das Relevanzproblem bei langen Artikeln? Mit farblichen Hervorhebungen. Es gibt ein bisher Chrome vorbehaltenes Feature namens “Link zum markierten Text kopieren”, welches Anchor Links generiert und Inhalte gelb hervorhebt. Browserunabhängig und regelmässig werden hingegen Texte von Featured Snippets hervorgehoben. Ein Beispiel direkt von WEBKINDER:

Diese Suchanfrage kann ein Featured Snippet für unseren Blogbeitrag zu WordPress Multisites auslösen. Klickt man darauf, wird die Antwort auf die Suchanfrage gleich farblich hervorgehoben:

Man kann Featured Snippets nicht forcieren. Anders als bei Structured Data muss man dafür die Inhalte auch nicht speziell aufbereiten. Google wählt die passenden Inhalte vollautomatisch aus und erklärt das in einem Artikel auf support.google.com. Gute Inhalte helfen natürlich dabei, womit wir zum nächsten Thema kommen.

Content ist immer noch King

Der Artikel oben ist bei weitem kein Einzelfall, lässt sich aber in ein Denkschema einbetten, welches gut mit folgendem Satz zusammengefasst werden kann: «Wir als SEOs müssen X». Das X steht dabei für die jeweils heissesten SEO Tipps, bestehend aus diesem oder jenem neuen Detail.

Fraglich ist, ob solche Aussagen überhaupt für SEOs geschrieben wurden, oder ob die Zielgruppe doch eher aus Unerfahrenen besteht, die ihre Webseite so schnell wie möglich optimieren wollen. Ist das der Fall, bedienen solche Artikel schlicht die Nachfrage und bekommen damit ihren Traffic, welcher ihnen wiederum Einnahmen generiert, weil sie den Suchenden Werbung auf ihrer Webseite anzeigen.

SEO und nachhaltige Ranking Verbesserungen benötigen Zeit und kontinuierlichen Aufwand. Natürlich sind die technischen Voraussetzungen ebenso wichtig wie die strukturierten Inhalte. Die Qualität und Originalität der Inhalte sind aber nach wie vor massgebend. Und zwar unabhängig von der Branche.

Ganzheitlich statt induktiv

Ein induktives Vorgehen ist deswegen von vornherein zum Scheitern verurteilt. Das kommt einem Stochern im Heuhaufen gleich: man pickt sich einige Halme heraus und verkündet stolz, die Nadeln darin gefunden zu haben. Dass aber der gesamte Haufen aus Nadeln besteht, sich ständig verändert und dass alle Nadeln einen unterschiedliche grossen Einfluss haben, ist zu kompliziert für einen auf Einfachheit und Reichweite ausgelegten Blogbeitrag.

Daraus folgt auch, dass es nicht genügt, einfach links und rechts einige der sich vermeintlich bewährenden Details der Konkurrenz abzuschauen. Das kann dann systematisch gemacht werden, wenn alle grundlegenden Optimierungen vorgenommen wurden, man deswegen bereits gut rankt und dann noch Zeit zum Experimentieren für den letzten Feinschliff bleibt.

Sauber durchgeführte Experimente wie zum Beispiel A/B Tests generieren dabei die aufschlussreichsten Daten. Und wie ich oben versucht habe zu zeigen, ist es immer ein Bündel aus technischen und inhaltlichen Faktoren, die ganz unterschiedliche Effekte pro Webprojekt haben können.

Diese hübsche Animation zur aufregenden Welt der Datenanalyse ist kein Gif, sondern eine Lottie Datei. Diese Art von Dateien und ihre Vor- und Nachteile haben wir in unserem Beitrag zu den Webdesign Trends 2022 vorgestellt.

«Google ranks web pages, not web sites»

In der deutschen Sprache wird nicht zwischen Webpage und Website unterschieden. Im Englischen besteht der Unterschied darin, dass web page eine einzelne Webseite meint, während web site eine Domain und die daran geknüpften Unterseiten bezeichnet. Dieser Blogbeitrag ist für sich genommen deswegen eine web page, zusammen mit webkinder.ch und all den anderen Unterseiten handelt es sich aber um eine web site.

Dieses Zitat von oben stammt angeblich von einem bekannten Google Webmaster, nämlich von John Mueller. Den ursprünglichen Tweet konnte ich leider nicht finden, gehe aber davon aus, dass er existiert hat, weil sich zahlreiche SEO Agenturen darauf berufen. Ihre Argumente gehen dann teilweise so weit, dass Google angeblich immer nur Webseiten einzeln bewertet und andere Unterseiten derselben Domain keinen Einfluss haben.

Das führt wieder einmal zu Kopfschütteln:

«… as SEO professionals realize that E.A.T. is not

Jenn Mathews, Search Engine Journal Ausgabe “SEO Trends 2022”, Seite 107

a ranking factor, Domain Authority doesn’t mean anything, and Google ranks web pages, not websites.»

Im Gegensatz zum oben zitierten Blog gehe ich hier davon aus, dass dieses Journal von SEOs für SEOs geschrieben wurde. Der Wow-Effekt für die Leserschaft besteht dann wohl darin zu behaupten, dass sich viele Expertinnen irren und einfach nicht wahrhaben wollen, so viel Zeit und Geld in ihre Domain Autorität investiert zu haben, obwohl sie angeblich nichts bringt.

Heftiges Kopfschütteln meinerseits. Und zwar nicht, weil das nicht plausibel ist. Die Sunk Cost Fallacy (auf Deutsch etwa “Der versunkene Kosten Denkfehler”) ist nicht unbekannt und kann dieses psychologische Narrativ passend erklären. Sondern weil diese Logik leider genau wie oben frei erfunden ist.

Statistische Grundlage: die Regressionsanalyse

Um einen Wirkungszusammenhang aufzeigen zu können, müsste ein Datensatz mit mindestens zwei Variablen vorliegen: Der Domain Autorität und dem Domain Ranking auf Google. Damit könnte eine Regression durchgeführt und ein Zusammenhang festgestellt werden. Mögliche Erklärungen könnten dann einzeln mit weiteren Variablen geprüft werden. Diese Aussage über die Domain Autorität ist deswegen mangels jeglicher Daten wieder nur eine reine Mutmassung.

Jenn Mathews bezieht sich auch auf einen Blog Artikel vom Search Engine Journal, geschrieben von Jeff Ferguson. Dieser meint als Ergänzung zum Zitat von John Müller: «Therefore, as far as ranking and indexing go, that webpage could live on any domain it likes, and Google would treat it the same way.».

Auch das ist wieder nur eine Annahme, weil die Beweise fehlen. Bezüglich der Logik habe ich einzuwenden, dass der Umkehrschluss fehlerhaft ist: nur weil Google möglicherweise web pages für sich genommen bewertet, bedeutet das nicht, dass die Bewertung der Domain oder einer ganzen Webseite keinen Einfluss auf das Ranking hat. Wirkungsrichtungen können nicht einfach beliebig umgedreht werden. Und Korrelation, wenn sie denn überhaupt in Zahlen ausgedrückt werden kann, bedeutet nun mal nicht Kausalität.

IndexNow

Zur Auflockerung eine Neuerung, welche 2022 an Fahrt gewinnen und zu einem SEO Trend werden könnte. Bei IndexNow handelt es sich um eine API mit simpler Funktionalität: nimmt man Änderungen an der eigenen Webseite vor, werden die Suchmaschinen angepingt. Das soll laut den Befürwortern zur schnelleren Indexierung von geänderten Unterseiten führen. Bisher wird IndexNow von Yandex und Bing unterstützt.

Die Syntax dabei lautet:

https://<searchengine>/indexnow?url=url-changed&key=your-keyDer Key kann ein beliebiger String sein, sollte aber nur den Suchmaschinen bekannt sein und in einer Datei im Root gehostet werden. Für diesen Blogbeitrag würde die URL entsprechend wie folgt lauten:

https://<searchengine>/indexnow?url=https://www.webkinder.ch/blog/strategie/seo-trends-2022/&key=webkinder-private-keyLaut dem Search Engine Journal testet Google IndexNow. Offizielle Informationen zum Test und zur Implementierung oder Ablehnung seitens Google gibt es noch nicht. Bing hat dieses Feature schon seit einiger Zeit im Einsatz. Es gibt auch ein von Microsoft Bing entwickeltes WordPress Plugin für IndexNow. Dabei kann zwischen manueller und automatischer Indexierungsbeantragung gewählt werden. Das Crawl Budget pro Tag für IndexNow, wenn es denn eines geben wird, ist bisher noch unbekannt.

Die Befürworter argumentieren, dass die Kontrolle den Webmastern zurückgegeben wird und dass das Indexieren deutlich schneller vonstatten gehen soll, weil die Suchmaschinen nicht mehr der robots.txt Datei oder der internen Verlinkung folgen müssen, um über Neuerungen zu stolpern, sondern stattdessen aktiv darauf hingewiesen werden können.

Ein paar kritische Inputs meinerseits für den Ausgleich der Waagschale: Sowohl der Einfluss auf die Qualität der Suchresultate als auch das Potenzial zur Ausnutzung ist fragwürdig. Für Letzteres würde eine Crawl Budget Limite Sinn ergeben. Für Ersteres hingegen müssten die Suchalgorithmen verbessert werden.

Dem Problem der Schnelllebigkeit (und der Hetzerei) der Gesellschaft wird damit nicht geholfen, weil in naher Zukunft möglicherweise für dieselbe Suchanfrage innert kürzester Zeit Resultate mit unterschiedlichen oder gar widersprüchlichen Aussagen angezeigt werden.

Eine weitere Kontroverse dürfte die Klimaverträglichkeit sein, weil jede zusätzliche Serveranfrage Energie kostet. Allerdings kannst du da als Webseiteninhaber:in bereits heute aktiv werden, wie wir in unserem Beitrag zum nachhaltigen Web gezeigt haben.

Alternative: Die Google Search Console

Google bietet mit dem Antrag zur Indexierung respektive Reindexierung in der Search Console bereits seit Jahren ein Tool mit ähnlicher Funktionalität. Dabei werden URLs einzeln geprüft und anschliessend deren Indexierung beantragt. Frustrierend kann dabei sein, dass man Google voll und ganz ausgeliefert ist bezüglich der Frage, ob und wann eine Webseite indexiert wird.

Die Erfahrung hat gezeigt, dass Google oft schlicht selbstständig über eine Unterseite befindet und die Search Console mehr als ein Aktualisierungstool für neue oder bereits rankende Unterseiten dient. Unterseiten, welche von Google zwar gecrawlt, aber nicht indexiert wurden, kriegt man mit einem Antrag zur Indexierung kaum in den Google Index.

Wohl nicht ganz unerwartet beschert uns das ein Wiedersehen mit Jenn Mathews:

«In 2022, SEO pros will stop talking about E.A.T. as a ranking factor. They’ll stop tweeting their domain authority numbers and won’t rely on their XML Sitemap submissions and their Robots.txt for managing the crawl budget.»

Jenn Mathews, Search Engine Journal Ausgabe “SEO Trends 2022”, Seite 110

Obwohl das eine Zukunftsvorhersage ist und deswegen natürlicherweise etwas Raum für Spekulationen beinhaltet, werde ich sie genauso zerpflücken wie die vorangehenden Statements.

Die E.A.T Faktoren sind wichtig

Die E.A.T Faktoren (ausgeschrieben und auf Deutsch für Expertise, Autorität und Glaubwürdigkeit stehend) waren noch nie direkt messbare Rankingfaktoren. Stattdessen gehören sie in denselben Heu- oder Nadelhaufen, den wir oben schon hatten. Hierfür gibt es eine direkte Google-Quelle: Danny Sullivan ist Search Liaison bei Google, was ich hier frei mit Öffentlichkeitsarbeit übersetze. In seinen Tweets weist er klar auf die Wichtigkeit von E.A.T hin:

Die E.A.T. Faktoren sind dementsprechend zentral für jede Webseite, insbesondere aber für Your Money Your Life (YMYL) Webseiten. Was es damit auf sich hat, haben wir an der hier verlinkten Textstelle in unserem Beitrag zu den Google Guidelines erklärt.

Zurück zum Mathews Zitat: Dass Kennzahlen über die Domain Authority getweetet werden, ist für mich eine irrelevante Behauptung, weil ich ausser Prahlen keinen Nutzen in der Veröffentlichung dieser Zahlen sehe, insbesondere keinen SEO Nutzen.

Der letzte Teil des Zitats über die XML Sitemaps und Crawl Budgets hingegen ist interessant, weil er wieder einmal aus der Luft gegriffen wurde. Sitemaps helfen Google dabei, Unterseiten zu finden. Ob eine Unterseite dann auch indexiert wird, liegt wie erwähnt bei Google. Man kann sich deswegen aus Prinzip nicht auf Sitemaps verlassen.

Seiten indexieren lassen – Crawlbudget beachten

Dasselbe gilt für die Crawl Budgets: Via Search Console lässt sich ein Antrag zur Indexierung stellen, mehr nicht. Wiederholte Beantragungen sind möglich, allerdings schreibt Google klar, dass die Anfrage deswegen nicht schneller verarbeitet wird. Geht es um die Zahl der Unterseiten, welche der Google Bot in einem Durchlauf crawlt, gibt es auch hier klare Regeln. Zum Beispiel im Handbuch für Inhaber großer Websites zur Verwaltung des Crawling-Budgets.

Wieder hilft hier das Sitemap und die robots.txt Datei, weil sie Google auf auf die vom Webmaster als wichtig markierten Unterseiten hinweisen. Die Kontrolle darüber, welche Unterseiten von Google indexiert werden, lag aber noch nie bei den Webmastern. Ich halte deswegen nichts von dieser Zukunftsvorhersage von Frau Mathews. Nur so am Rande bemerkt: Sie arbeitet als SEO Managerin für GitHub. Es darf einmal leer geschluckt werden.

Weiter mit den SEO Trends fürs 2022. Das nächste Thema hat sich bereits in den letzten paar Absätzen angekündigt. Wird die Entscheidungsmacht von Google als positiv gesehen, kann von Qualitätskontrolle gesprochen werden. Sieht man sie hingegen als negativ, würde ich von lästiger Bevormundung sprechen. Das bringt uns zur Nutzerabsicht. Google muss diese den Suchenden zwangsweise unterstellen, um dafür relevante Ergebnisse ausliefern zu können.

User Intent stellt alles andere in den Schatten

Hier bringe ich gerne auch mal ein Zitat mit einer Kernbotschaft an, die ich voll und ganz unterstütze. Sollte man sich nur einen einzigen Suchmaschinentrend aus diesem Artikel merken können, würde ich den Fokus hier drauflegen:

«Kristina Azarenko, SEO Consultant & Founder of MarketingSyrup Digital Inc., believes it’s time for people to finally “stop thinking in terms of ‘SEO content’ and create content for users with the intent and keywords in mind.”»

Danny Goodwin, Search Engine Journal Ausgabe “SEO Trends 2022”, Seite 13

Interessanterweise bringt uns das zum Anfang mit den beiden Business Cases zurück, weil diese Beschreibung wieder die Interessen aller Parteien – inklusive derjenigen der Suchenden – berücksichtigt. Werden Inhalte aufgrund von diesem oder jenem SEO Tipp nur für einige Details optimiert, kann darunter der gesamte Inhalt leiden. Über- oder Unterläge, zu viele oder zu wenig Bilder und Kuriositäten wie Keyword Spamming sind die Folge.

Eine ganzheitliche Vorgehensweise ist da deutlich sinnvoller. Dabei rückt neben einigen Grundvoraussetzungen wie den Core Web Vitals und den EAT Faktoren auch die Nutzungsintention immer mehr in den Fokus. Wie Herr Goodwin das oben formuliert hat, geht es dabei darum, sich zu fragen, nach was die Suchenden denn eigentlich auf der Suche sind und mit welchen Keywords sie danach suchen könnten.

Webseiten generieren innerhalb von weniger als 50 Millisekunden bereits einen ersten Eindruck. Dabei spielen sowohl das Webdesign (Webdesign Trends für 2022 haben wir hier vorgestellt) wie auch die Relevanz der Inhalte eine Rolle. Neu ist diese Information nicht, Google hat sie bereits in einer Studie von 2012 erwähnt.

Suche ich dementsprechend nach einem Rezept, möchte ich weder mit Werbung, noch mit Pop-ups, einer Liebesgeschichte oder SEO Tipps überrascht werden. Und kriege ich bei einem Seitenaufruf innerhalb der ersten Momente nicht den Eindruck, das finden zu können, wonach ich eigentlich suche, springe ich direkt wieder von der Webseite ab.

Den User Intent hinter diesen Suchanfragen versteht Google dank Mum besser denn je. Es dauert zwar noch einen Moment, bis die algorithmische Verarbeitung der menschlichen Sprache ausgereift ist. Allerdings existiert die Technologie bereits und wird aktiv von Google verbessert und gemäss dem verlinkten Artikel innerhalb der nächsten Monate und Jahre in die Angebote von Google integriert.

Das geht Hand in Hand mit den sich mittlerweile multimedialen und über diverse Kanäle erstreckenden Kundenreisen. Ist das Ziel der Reise bekannt, kann Google die Suchenden effizienter mit relevanten Informationen dahin führen. Diesem Euphemismus gegenüber stehen natürlich auch dystopische An- und Aussichten. Fakt ist allerdings, dass Customer Journeys bereits heute getrackt, ausgewertet und auch verwertet werden.

Wiederkehrende Nutzerinnen trotz initialem Absprung

Google widmet den immer komplexer werdenden Customer Journeys eine eigene Kategorie auf der Think With Google Webseite. Die Menschen vergleichen ihre Optionen zuerst über mehrere Webseiten, bevor sie eine Entscheidung fällen. Dass Absprünge ein natürlicher Teil davon sind, geht dabei leicht vergessen.

Denn es lässt sich auch argumentieren, dass zufriedene User eher wieder zu einer Webseite zurückkehren, selbst wenn sie initial abgesprungen sind. Ein positives Nutzererlebnis ist deswegen weitaus wichtiger, als zu versuchen, die Leute mit Tricksereien auf der Webseite zu halten.

Ist die Nutzerabsicht Informationsbeschaffung, sollten Webseiten genau diese Informationen anbieten. Geht es hingegen zum Beispiel um einen Verkauf und wurde ein Produktvergleich bereits durch die Interessenten durchgeführt, befinden sie sich schon eine Stufe tiefer im Verkaufstrichter und sind nun womöglich direkt an Angeboten interessiert. Wie man die eigenen Produkte in den kostenlosen Google Shopping Ergebnissen anzeigen lassen kann haben wir übrigens im verlinkten Beitrag erklärt.

Und welches Narrativ drängt sich hier wieder auf? Genau: mit einer guten User Experience ist allen Parteien geholfen. Inhaltliche und technische Tricksereien werden von Google ausserdem zusehends bestraft, weswegen sich die schnelllebigen SEO Tipps auch nicht bewähren.

Deswegen reicht es auch, sich auf die Intention der Suchenden zu konzentrieren und ihnen schnell gut strukturierte und relevante Inhalte zu liefern. Oder anders: Stimmen die Inhalte (und ein paar technische und designerische Grundlagen), kommen die Leute von selbst.

Punkto Strafen gibt es aber noch einen Input für 2022, den ich eben aufgreifen möchte:

Barrierefreiheit als Trend

Die Frage danach, inwiefern Tech Giganten wie Google mit Behinderungen umgehen, könnte 2022 deutlich an Fahrt aufnehmen. So denkt unter anderem Christina Levasseur, Gründerin und SEO Beraterin von MediaSesh. Sie ist ebenfalls im Search Engine Journal mit ihren Ansichten vertreten, auf Seite 44 und 45.

Wie für so viele andere komplexe Themen auf der Welt gibt es auch einen Haufen verschiedener Standards für behindertengerechtes Webdesign. Eine Google Mitarbeiterin und ein Google Mitarbeiter sind aktiv an der Entwicklung der Web Content Accessibility Guidelines beteiligt, was Google hier schreibt. Dann gibt es noch das VPAAC und das CAC Komitee. Dazu kommen natürlich noch die eigentlichen Gesetze der jeweiligen Staaten, selbst wenn diese der Technologie teils deutlich hinterherhinken.

Angesichts der Allgegenwärtigkeit des Internets und der Digitalisierung von staatlicher Infrastruktur ist es für mich eine Frage der Zeit, bis die Gesetzgebung behindertengerechte Webseiten vorschreibt. In der Schweiz gilt das übrigens bereits, allerdings nur für für staatliche Behörden, nicht aber für Private. (Siehe dafür Art. 14 des Behindertengleichstellungsgesetzes BehiG).

Obwohl es im nachfolgenden Satz dem Kontext des Gesetzesartikels folgend ebenfalls nur um Behörden und nicht um Private geht, sind die Möglichkeiten für zukünftige Gesetze klar impliziert: «Er [der Bundesrat] kann technische Normen privater Organisationen für verbindlich erklären.» (BehiG, Art. 14).

Und sind es nicht die Staaten oder Google, können gemäss Frau Levasseur sehr wohl die User ihrem Unmut Luft verschaffen und Firmen ohne behindertengerechtes Angebot boykottieren (Search Engine Journal Seite 45). Sie zieht auch den Vergleich zu SEO Optimierungen:

«What works for accessibility in many cases works for SEO efforts – it’s not always the case when reversed. It’s like the saying: “If we’re not intentionally inclusive, we are unintentionally exclusive.”»

Christina Levasseur, Search Engine Journal Ausgabe “SEO Trends 2022”, Seite 45

Google demonstriert das unglücklicherweise gleich selbst:

«Einer der Grundsätze von Google lautet: “Der Nutzer steht an erster Stelle – alles Weitere folgt von selbst.”»

https://www.google.com/accessibility/initiatives-research/

Nutzerinnen gehen dabei wohl leer aus. Immerhin ist die Englische Version geschlechtsneutral. Damit haben wir Nationalstaaten und User als mögliche Bestrafer*innen für behindertenungerechte Webseiten identifiziert. Fehlt noch Google selbst.

Ist Barrierefreiheit ein Rankingfaktor?

Nicht direkt. In den Google Richtlinien für Webmaster sind bisher noch keine Regelungen zu behindertengerechtem Design festgehalten worden. Allerdings zieht John Mueller den direkten Vergleich zu SEO und argumentiert, dass schwer zu benutzende Seiten (sprich Webseiten mit schlechter UX) generell an Nutzerinnen und Nutzer verlieren werden:

Ob und wann Google also Guidelines für behindertengerechtes Webdesign für Webmaster erlässt, bleibt offen. Google entwickelt aber bereits Produkte zur Inklusion von behinderten Menschen, so zum Beispiel das Projekt Relate. Dabei wird eine App zuerst von sprachbehinderten Menschen trainiert und anschliessend zur erleichterten Kommunikation mit anderen Menschen oder Programmen genutzt (z.B. Google Assistant).

Um die Argumentation von John Mueller aufzugreifen: auch SEO Optimierungen können zur Verbesserung der Zugänglichkeit für Menschen mit Behinderung dienen. Das Ziel sollte es deswegen sein, Inhalte so zugänglich und strukturiert wie nur möglich zu machen. Dabei helfen:

- Sitemaps

- Breadcrumbs

- Treffende Alt-Texte

- Einfache Sprache

- Screen Reader Optimierungen

- Hohe Kontraste im Design

- Semantisches HTML

- Autofill bei Formularen

- Video/Audio/Bild Transkripte

Barrierefreiheit auch als Design Trend

Ein Blogbeitrag von Bet Hannon hat sich dem Thema im Detail angenommen und 13 Design Trends für behindertengerechtes Webdesign herausgearbeitet. Hier die Kernaussagen:

- Farben: Auf hohe Kontraste achten, Farbenlehre für gewünschte Emotionen in Betracht ziehen (darauf sind wir in unserem Beitrag Webdesign Trends 2022 eingegangen)

- Navigation: Das Wort Menü ausschreiben anstatt nur ein für unerfahrene User verwirrendes Hamburger Icon verwenden (was eine gute Navigation ausmacht und warum sie wichtig ist haben wir in unserem Beitrag SEO Relaunch erklärt)

- Responsiveness: Seit Jahren unverzichtbar, leider noch nicht allgegenwärtig und leider auch mit dem nachteiligen mobile first Ansatz umgesetzt

- Auf custom scrolling verzichten: Mag zwar für einen initialen Wow-Effekt sorgen, führt aber auch schnell zu einer frustrierenden UX wegen der erschwerten Navigation und den häufig verlängerten Ladezeiten

- Verzicht auf zu viel Interaktivität, bewegten Content und visuelle Daten: Führt zu denselben Problemen wie oben (stattdessen auf einen guten Mix zwischen animierten Elementen und Seitenladegeschwindigkeit achten)

- SEO für sprachgesteuerte Suchen: Siehe den Absatz direkt unterhalb des Tweets von John Mueller

- Lokale SEO (Standortoptimierungen): Ein schnell an Bedeutung gewinnender SEO Trend, mit einem Beispiel von Google ein paar Absätze weiter unten (Wie man Google My Business einrichtet)

- Seitenladegeschwindigkeit: Schon seit Jahren essenziell für jede Webseite und deswegen von uns auch bereits häufig aufgegriffen worden, sogar mit einem eigenen Blogbeitrag zu den Pagespeed Insights, Ladezeiten, Rankings, technischen Erklärungen und weiteren Tools

Behindertengerechte Webseiten helfen also wieder allen Parteien: den behinderten Usern, den Unternehmen, die mögliche neue Kundinnen gewinnen und natürlich auch Google, sei es nun aus altruistischen oder marktwirtschaftlichen Gründen.

SEO Automatisierung durch Machine Learning

Bots, die Inhalte schreiben, gibt es schon seit Jahren. Zu Beginn waren die Texte noch etwas holprig und unleserlich, mittlerweile kommen sie aber in so hoher Qualität daher, dass man sie nicht mehr eindeutig einem Menschen oder einer Maschine zuordnen kann. Die von den Marketingteams angepriesene Qualität der Sprache ist dabei aber nur ein Teil der Rechnung.

Solange die Maschinen die Inhalte nicht verstehen und nur aufgrund von heuristischen oder statistischen Mustern ähnliche Inhalte reproduzieren, schaffen sie nichts neues und damit auch keinen Mehrwert, sondern nur abgeänderte Kopien. Das kann äusserst hilfreich sein, wenn es um Wiederholungen geht. Beispielsweise bei der Wortwahl, der Satzstruktur oder auch bei Übersetzungen.

Neue Zusammenhänge oder Aussagen können damit aber nicht produziert werden. Es sei denn, sie sind zufällig richtig. Das bedingt wiederum den Menschen und einen Haufen Arbeit, um die Texte gegenzulesen und deren zufällige Logik zu beurteilen, weil maschinell aneinandergereihte Sätze zwar konsistent, aber eben noch nicht kohärent sind.

Und wie steht es um SEO Tools? Auch hier ist Machine Learning auf dem Vormarsch, aber nicht ohne den Menschen nutzbar. Ein Tool namens Falcon AI zum Beispiel wirbt mit der automatisierten Analyse von mehreren Tausend SEO Keywords pro Monat. Der USP ist die gesparte Zeit bei der Keyword Recherche und die thematische Ausweitung der Keywords, welche über klassische Tools weit hinausgehen soll. Zudem bietet das Tool automatisiert generierte Titel an, welche sich an den top 10 Suchresultaten für das jeweilige Thema orientieren.

«The result of this is we can generate high-performance titles that perfectly reflect the search intent, as they’re based on what’s actually ranking.»

Alex Denning, getellipsis.com/blog/falcon-ai-20k-keywords

Wie wir bereits in unserem Beitrag zu den Google Guidelines gezeigt haben ist Google selbst ständig darum bemüht, die Suchintention der User besser zu verstehen und mit relevanten Resultaten zu beantworten. Dieses Zitat suggeriert hingegen, dass es sich bei den top rankenden Suchresultaten bereits um die bestmöglichen Resultate handelt. Dem kann ich so nicht zustimmen.

Natürlich kann dagegen gehalten werden, dass es darauf schlicht nicht ankommt, solange man in den top 10 Suchresultaten erscheint. Kurzfristig mag das noch funktionieren, langfristig gehe ich aber davon aus, dass Google dieses Kopieren-Generieren Verhalten besser erkennen und abstrafen wird.

«Our hypothesis is we’re doing a much better job than competitors of providing relevant, insightful content to the searcher. Google is recognising this and thus rewarding our content.»

Alex Denning, getellipsis.com/blog/falcon-ai-20k-keywords

Nur weil die automatisch generierten Keywords ein thematisch zwar relevantes, aber grösseres Feld abdecken, heisst das noch lange nicht, dass die Inhalte auch gut sind.

Tools oder wie hier Machine Learning mögen dabei helfen, Inhalte zu kreieren, aber die wichtigen Punkte wie Originalität, Relevanz, Benutzerfreundlichkeit und Glaubwürdigkeit können damit weder messbar gemacht noch verstanden und deswegen auch nicht reproduziert werden.

Es braucht den Menschen also vorerst immer noch.

Continuous Scroll

In diesem Fall legt Google vor. Das ist deswegen auch kein Trend, sondern eine Ankündigung seitens Google und damit schlicht ein Einblick in die Zukunft. Letzten Oktober wurde die Änderung vorgestellt und für Englische Suchergebnisse in den USA ausgerollt. Der Rest der Welt wird wohl bald folgen.

Man siehe sich das Verhältnis von Structured Data zum klassischen Format mit einem Link, einem Titel und einer Meta Description an. Strukturierte Daten dominieren hier klar, insbesondere die Bilder. Ohne SEO optimierte Bilder in diese Rich Results aufgenommen zu werden dürfte äusserst schwer werden.

Ausserdem ist das ein gutes Beispiel für User Intent: nach was suchen die User eigentlich, wenn sie “Was kann ich mit Kürbissen machen” eingeben? Google stellt hier Resultate aller Art vor, weil die Frage mehrdeutig ist. Das reicht von einer Sammlung mit Ideen über Rezepte hin zu Blogbeiträgen und sogar Gaming Anleitungen.

Und was, wenn die Suchabsicht ein Bild ist? Google hat auch dafür eine Antwort. Mit der Google Lens können bereits heute Objekte fotografiert und online nach ähnlichen Ergebnissen gesucht werden. Die umgekehrte Bildsuche ist nichts neues, die globale Kommerzialisierung davon hingegen schon. Noch ein Video zur Veranschaulichung:

Utopisch oder dystopisch? Weder noch, weil es bereits Realität ist. Möchte man mit den eigenen Dienstleistungen, Produkten, Webseiten etc. bei diesen Neuerungen mitmischen, müssen die SEO Empfehlungen von Google und damit Structured Data beachtet werden. Bei Produkten gehören zum Beispiel die Ladenöffnungszeiten ebenso dazu wie der Standort (und die für die Suchanfrage relevante Lokalisierung des Users durch Google) die Artikelnummer oder die Lagerverwaltung.

Im Entwurf zu diesem Artikel werden nachfolgend noch ca. fünf weitere Themen vorgestellt. Allerdings haben wir mit diesem Abschnitt die SEO Vorgabe von mindestens 2000 Wörtern (um gut zu ranken) mit knappen 5000 Wörtern bereits schon mehr als zweimal erreicht. Und wie wir gelernt haben, kann das ja nur bedeuten, dass er gut ranken wird und damit auch lange genug ist. Spass und Spott beiseite bleibt aber noch Raum für ein kurzes Fazit. Die anderen Themen heben wir uns für den nächsten relevanten Beitrag auf.

Fazit

EAT, MUM, BORIS, LENS, RELATE, USER INTENT und wie die hübschen Buzzwords nicht alle heissen: Keyword Spamming ist schon seit den späten Neunzigern out. Wer heute nicht eine Symbiose mit Google eingeht und denn Sinn hinter den Grundanforderungen der Richtlinien für die Inhaltsoptimierung versteht, wird Opfer von diesem und jenem neuen flüchtigen SEO Trend und optimiert an den Usern und damit auch an Google vorbei.

Eine Zauberformel für SEO Erfolge gibt es nicht. Dabei wäre es aber einfach, die eigene Webseite zu optimieren und damit den Usern, Google und nicht zuletzt sich selbst massiv zu helfen: Originelle, qualitative und multimediale Inhalte suchmaschinengerecht, d.h. strukturiert, so aufbereiten, dass die Suchintentionen (inklusive Keywords) der User schnell beantwortet werden können.

- Artikel übersprungen und verwirrt? Zurück zum Anfang.

- Alles gelesen und Lust auf mehr? Unser Blog voller Einsichten rund um Google und Webtechnologien.

- Auf den Geschmack gekommen und begeistert über das Potenzial zur Verbesserung des eigenen Webangebots? Kontakt mit uns aufnehmen und klären, was wir für dich und dein Webangebot tun können.